2019年11月01日

時代が求める「説明可能なAI」

世界で注目されている「AIの説明可能性」

説明責任とは、企業経営者や政治家や医師など成果責任が問われる職種で使われていた言葉ですが、「AIの説明可能性」とはAIが関わった判断に対しても説明することを指します。昨今、AI技術が格段に進歩し、重要な判断にもAIが関与するケースが出てきています。たとえば、経営者が投資先の判断にAIの分析結果を利用したときでも、経営者は各ステークホルダーに対して何故その判断を行ったのかを説明する必要があります。またAIの分析結果が精度の低いものであったり公平でなかったりすると、利用者や関係者による判断の失敗や意図としない認識による弊害が発生します。現在AIの説明可能性については世界中で重要視されていて、政府の専門調査会で提出された『「人間中心」のAI 7原則』では、「公平性、説明責任、透明性」を挙げています。また、2019年のG20大阪サミットで採択された『「人間中心」AI開発』にも「透明性及び説明可能性」として留意することとされています。※1

※1:G20 AI原則(仮訳)

https://g20.org/pdf/documents/jp/annex_08.pdf

現在の技術で可能なAIの結果説明

AI技術のうち「機械学習」が判断や予測によく使用されます。機械学習では、なぜそのような結果になったかについて理由やプロセスは示されないため、その結果が得られた根拠を正確に理解し、関係者へ説明することは一般的な企業にとって極めて困難です。では、AI原則に従って透明性及び説明可能性を満たすために、現在どのようなことができるのでしょうか。

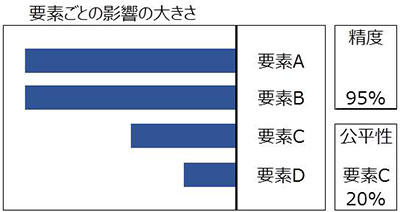

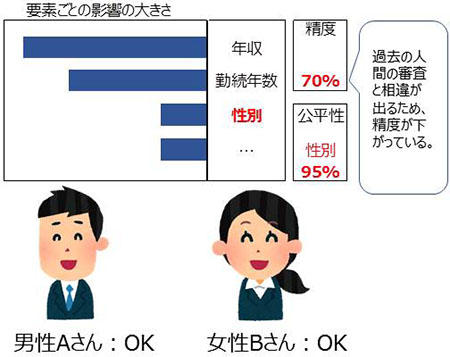

最近ではIBMをはじめ各社がAIの説明可能性の原則を満たすための製品をリリースし始めています。たとえば、分析結果にどのような要素が関係したか、分析結果の正確性を示す「精度」と「公平性」がわかります。公平性とは、分析結果に偏りがないかの指標です。そして、結果に偏りがあれば、それを可視化して偏りを緩和することができます。 図1では要素Cの公平性が20%で偏りがあることを示しています。

図1:AIの分析結果を説明する製品表示例

なぜ公平性や精度をチェックすべきか

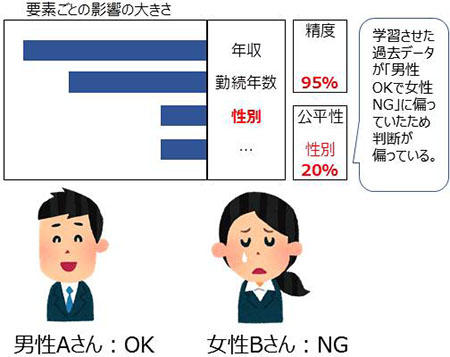

機械学習が示す分析結果は過去の実績から予測するため、過去の実績が偏っていればその結果も偏ります。分かりやすく極端な例を挙げてみます。ある会社がローンの与信審査をさせるために学習させたデータが「男性はOKで女性はNG」という性別による偏りがあるとすれば、その機械学習が示す判断結果にも性別による偏りが発生します。本来性別は代金を回収できるかどうかという与信結果に影響するものではないため、これは「公平」であるとは言えなくなり訴訟のリスクを抱えることになります。しかし、機械学習の結果は、この会社がこれまで蓄積してきた偏りを含んだ審査結果と同様の結果を示したことから「精度」は高いといえます。このように精度と公平さは異なる指標であり、時には相反してしまう場合があります(図2:公平性と精度の例)。公平性は機械学習においても留意すべき項目であることは言うまでもなく、機械学習を使用して判断を行おうとする企業は結果について説明できるようにしておく必要があります。

■性別の公平性が低い例

(他の条件が同じでも性別で判定が変わる)

■性別の公平性を高くするように変更した例

(AIの振舞いを変更したため女性もOK)

図2 :公平性と精度の例

透明性や説明可能性についてはまだまだ技術が追いついていませんが、AIが重要な判断に活用できるようになればなるほど要求は高度化されていくと考えられます。今後、AIの精度と公平性がより高度化されると、よりAIの結果が信頼できるものとなり人間の判断に恩恵をもたらすようになるでしょう。

2019年11月

最新の記事

年別

ITの可能性が満載のメルマガを、お客様への想いと共にお届けします!

Kobelco Systems Letter を購読