2023年07月01日

AIからの答え、その根拠は?

~説明可能なAI~

はじめに

昨今、あらゆる企業や団体、組織で人工知能(以下、AI)の活用が進んでいますが、ChatGPT※1の登場により、一般の人々にもAIがより身近な存在になったと感じます。2023年5月13日、東京大学の学園祭「五月祭」で、ChatGPTを裁判官にした模擬裁判のイベントが開かれたというニュースがありました。いくつか課題はあるものの、法律の専門家から見ても判決に至るまでの内容や判決理由の述べ方が非常に精度の高いものだったようです。一方でAIが人間を裁くことの是非にも注目が集まりました。

年々AIによる判断や予測の精度は向上していますが、その結果が人間にとって信頼できるものかどうかは別の問題です。ビジネスにAIの活用を検討していても判断や予測の根拠がブラックボックスという理由で導入を見送るケースもよくあります。特に近年主流になっているディープラーニング※2とよばれるAIモデルはその構造が複雑で、従来の機械学習モデルよりブラックボックス化しやすいという特徴があります。例えば、人の生命に直結するような医療分野においてこの問題は非常に深刻です。AIが医師に代わって病気の診断をする際に、診断の根拠がブラックボックスではAIの判断を安心して受け入れることはできません。

説明可能なAIとは

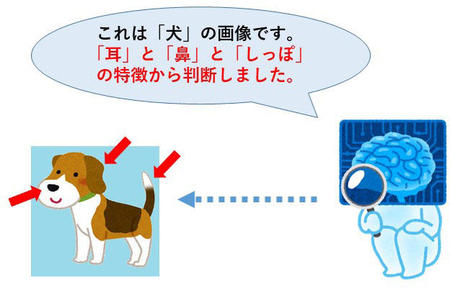

説明可能なAI(Explainable AI、XAI)については、以前このコラム※3でもご紹介しましたが、今回は前回のアップデートという形でご紹介します。説明可能なAI とは、AIの判断に対し、なぜそのような判断に至ったのかについて人間が理解できるようにする技術の総称です。例えば、画像認識を行うAIに対してある画像を与え、その画像が犬であると判断されたとします。そこに説明可能なAI技術を活用すれば判断結果に加えてその根拠も示してくれます(図2)。

画像データだけでなく、テキストや表、数値データに対する説明可能なAI技術も存在します。

説明可能なAIの具体例

数ある説明可能なAI技術の中でも代表的な「LIME(Local Interpretable Model-agnostic Explanations)※4」とよばれる手法を使った画像認識の具体例をご紹介します。

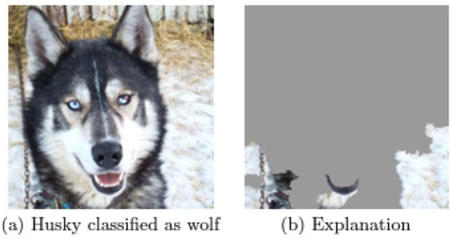

LIMEは予測を行うAIモデルと組み合わせて使用することで、そのAIモデルの予測結果に対して人間が理解しやすい根拠を示します。「ハスキー犬」と「狼」の写真を学習させたある画像認識AIに図3 (a)の画像を与えて、「ハスキー犬」か「狼」のどちらであるかを判定させます。

その結果、AIは画像を「狼」と判断しましたが、正解は「ハスキー犬」です。ではなぜAIはこのような判断ミスをしてしまったのでしょうか?判定結果だけではその原因がどこにあるかは分かりません。しかし、LIMEを活用すれば、AIが画像のどこに注目して「狼」と判定したのかを可視化できます。図3 (b)のLIMEによる可視化の結果を見ると、AIがハスキー犬の顔ではなく、背景の雪を根拠に判定を行ったことがわかります。このことから、AIに学習させた狼の画像データには雪のような白っぽい背景のものが多かったのではないかと容易に推測ができます。

また、LIMEは画像データだけでなく、テキストや表形式のデータにも適用ができます。

図3:LIMEを使用した画像分類の可視化

図3:LIMEを使用した画像分類の可視化

出典:『"Why Should I Trust You?": Explaining the Predictions of Any Classifier』※4より抜粋

https://arxiv.org/abs/1602.04938

(クリックして拡大できます)

最近の動向

「説明可能なAI」という言葉が広く使われるようになったのは、2017年にアメリカの国防高等研究計画局(DARPA)がAIの説明可能性に関する研究プロジェクトを発表したことがきっかけと言われています。日本でも2018年に内閣府が発表した「人工知能技術戦略実行計画※5」の中で「説明できるAI技術の開発」が重点的に取り組むべき研究開発の施策として挙げられ、“機械学習による学習・推論結果について、人間が理解できるように説明し、信頼性を向上させる技術を開発”という目標が明記されています。また、2020年に文部科学省が発表した戦略目標である「信頼されるAI※6」の中でもAIの説明可能性について言及されています。

「信頼されるAI」の発表をきっかけに、国立研究開発法人 科学技術振興機構(JST)の戦略的創造研究推進事業※7において「信頼されるAIの基盤技術」という研究領域が新たに発足しました。2020年の発足以降、様々な大学や企業の研究者が参加し、毎年多くの応募の中から研究テーマが採択されています。2022年度には10個の研究テーマが採択され、その中には人間の神経や筋の生体情報を利用して説明可能なAIの信頼性を検証するといった研究も含まれています。

まとめ

ChatGPTをはじめとする生成系AIの登場でAIが身近になったことでAIの信頼性にも今まで以上に高い関心が集まるようになり、AIの説明可能性はますます重要になっています。AIが判断して回答した根拠は明示されなければならないでしょう。今後説明可能なAI技術がさらに発展し、人々が様々な場面で安心してAIを活用できるような社会の実現を期待します。

※1:ChatGPTはGoogleを超えられるのか

https://www.kobelcosys.co.jp/column/itwords/20230301/

※2:ディープラーニング … 機械学習の一手法。データのどの部分に注目するか(特徴量)をコンピュータ自身が自動で決定する。従来の機械学習は人間が特徴量を決定。

※3:時代が求める「説明可能なAI」

https://www.kobelcosys.co.jp/column/itwords/20191101/

※4:Marco Tulio Ribeiro, Sameer Singh, Carlos Guestrin, 『"Why Should I Trust You?": Explaining the Predictions of Any Classifier』(LIME原論文)

https://arxiv.org/abs/1602.04938

※5:人工知能技術戦略実行計画(内閣府)

https://www8.cao.go.jp/cstp/tyousakai/jinkochino/keikaku.pdf

※6:信頼されるAI(文部科学省)

https://www.mext.go.jp/b_menu/houdou/2020/mext_00487.html

※7:戦略的創造研究推進事業 … 日本が直面する重要な課題の克服に向けて、挑戦的な基礎研究を推進し、社会・経済の変革をもたらす科学技術イノベーションを生み出す、新たな科学知識に基づく創造的な革新的技術のシーズを創出することを目的とする。研究テーマが採択されれば研究費の支援を受けられる。

https://www.jst.go.jp/kisoken/about/index.html

2023年7月

ITの可能性が満載のメルマガを、お客様への想いと共にお届けします!

Kobelco Systems Letter を購読最新の記事

年別

他の連載・コラム

Webでのお問い合わせ

お問い合わせ